本篇学习报告主要介绍一篇发布于2020年cvpr的论文《clusterfit: improving generalization of visual representations》。

背景:

现如今,在许多视觉任务上,受限于对数据集真实标签的获取难度,由自监督或半监督预训练而成的卷积神经网络变得越来越受欢迎。然而,由于在预训练过程中缺乏强区别性信号(即显著特征),这些方法学习到的特征很容易与预训练目标过拟合,进而无法很好地推广到下游任务。因此,该论文提出了一个简单却有效的方法:clusterfit。该方法可扩展到不同的弱监督和自监督预训练框架中。作者通过对多个不同目标数据集进行迁移实验,证明了clusterfit可以显著提升模型的泛化能力。

方法:

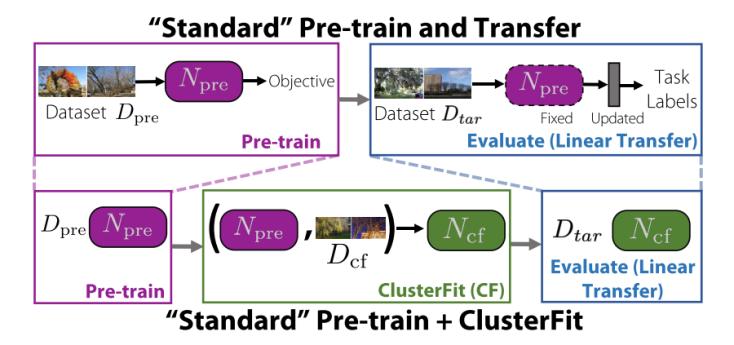

如图所示,clusterfit的实现流程可概括为:①首先,给定一个卷积神经网络npre,该网络先在预训练数据集dpre上做分类任务,因此npre具有一定的特征提取能力。②第二步,让预训练过的npre在目标数据集dcf上采用k-means聚类算法,将数据集划分成k个groups,将groups所代表的聚类标签作为原始图像的伪标签。③从头开始初始化一个新的卷积神经网络ncf,让其在dcf上做伪监督分类任务,此处采用的伪监督信号lcf即为前文中由npre所提供的聚类标签,由于ncf在训练过程中未使用dcf的原始标签,所以该方法可认为是无监督的,损失计算方法采用交叉熵损失。④在ncf和npre尾部均加上一层线性层,在目标数据集dtar进行线性验证,检验两种方法所学特征的泛化能力。

实验:

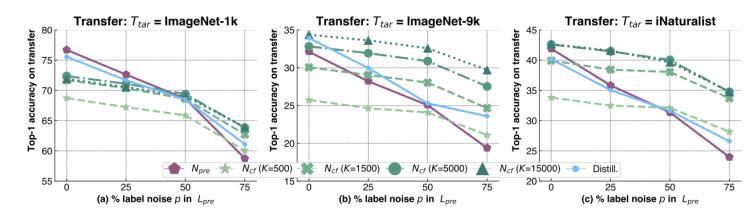

基本实验设置:设置npre和ncf均为resnet50,dpre和dcf均为imagenet-1k,图中的横坐标p代表在npre预训练过程中加入多少百分比的噪声标签,对应每一个百分比,作者都训练出一个与npre相对应的ncf,最后再用ncf在三个数据集(imagenet-1k,imagenet-9k,inaturalist)上验证npre的泛化能力。

在图(a)中,当p为0时,npre的表现要优于各个k值下的ncf,这种情况是合理的,因为此时dpre和dtar均为imagenet-1k,并且预训练任务和迁移任务均为无噪声条件下分类任务,但随着p值的增大,迁移任务转化为在有噪声标签条件下的分类任务时,ncf的表现要逐渐相似甚至优于npre,这证明了clusterfit所学习到的特征更具备泛化性。

在图(b)和图(c)中,当dtar与dpre不同时,ncf的表现普遍优于npre,并且在聚类个数越多的情况下,clusterfit的迁移能力越强,这进一步说明了应用clusterfit所学习到的特征可以很好地推广到下游任务。

文中还验证了在多种模态下(例如图像,音频等)的消融试验,clusterfit所取得的效果依然令人满意。

学习总结:

本文提出的clusterfit可以显著提高在弱监督和自监督框架中学习的图像和音频特征的泛化能力。clusterfit首先通过对原始特征空间进行聚类并重新学习聚类分配的新模型来解决过拟合预训练目标的问题,预测聚类标签为“relearn”的网络提供了一个学习对原预训练目标非敏感特征的机会,使它们更具可迁移性。最重要的是,clusterfit是一个通用的框架,对模型,数据类型,监督形式均无任何限制,可以很便捷地嵌套进现有的框架当中,提升现有模型的鲁棒性。

论文地址:https://arxiv.org/pdf/1912.03330.pdf

撰稿人:林烁彬

审稿人:何乐为